KI-Erkenntnisse in verständliche Sprache übersetzen: Wie MIT-Forscher komplexe Erklärungen vereinfachen

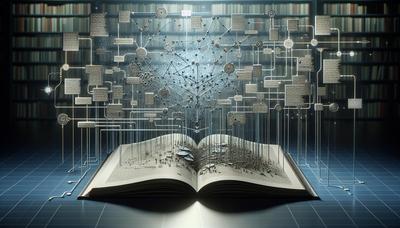

BerlinMIT-Forscher entwickeln eine neue Methode, um AI verständlicher zu machen. Sie setzen große Sprachmodelle ein, um komplexe AI-Erklärungen in leicht verständliche Texte zu verwandeln. Dies ist besonders wichtig für Menschen ohne Kenntnisse im Bereich maschinelles Lernen, die mit technischen Details und komplizierten Erläuterungen Schwierigkeiten haben.

- Vertrauen stärken: Durch verständlichere Erklärungen können Nutzer besser einschätzen, wann sie sich auf die Vorhersagen eines Modells verlassen können.

- Entscheidungsfindung verbessern: Mit klareren Einblicken können Nutzer fundierte Entscheidungen treffen, insbesondere in Bereichen wie Finanzen oder Gesundheit.

- Individualisierung fördern: Das System passt sich den Vorlieben der Nutzer an und wird dadurch vielseitig einsetzbar.

Das EXPLINGO-System besteht aus zwei Komponenten: dem NARRATOR und dem GRADER. Der NARRATOR verwandelt komplexe SHAP-Erklärungen mithilfe eines Sprachmodells in leicht verständliche Texte. Dabei passt er den Schreibstil anhand einiger Beispieltexte an. Der GRADER bewertet die Klarheit, Genauigkeit, Vollständigkeit und Flüssigkeit der Erklärung, um die Qualität sicherzustellen.

EXPLINGO verwendet eine sorgfältige Methode, um KI-Erkenntnisse zu übersetzen. Statt Erklärungen direkt mit einem großen Sprachmodell (LLM) zu generieren, nutzt EXPLINGO das LLM lediglich zur Sprachmodifikation, was hilft, Fehler zu vermeiden. Diese Vorgehensweise macht die Ergebnisse zuverlässiger und benutzerfreundlicher. Der Fokus auf SHAP-Erklärungen ist bewusst gewählt, da diese weit verbreitet sind, um die Wichtigkeit verschiedener Merkmale in einem Modell darzustellen.

Die Forscher hatten Schwierigkeiten, das Sprachmodell so anzupassen, dass es natürliche Sprache erzeugt, ohne an Genauigkeit einzubüßen. Sie mussten sorgfältig ausbalancieren, wie die Sprache klingt und wie korrekt sie ist, indem sie detaillierte Anpassungen an den Eingaben vornahmen. Dieser Prozess ist entscheidend, da unklare Anweisungen zu ungenauen Ergebnissen führen können.

Zukünftig könnte EXPLINGO es den Nutzern ermöglichen, mehr Fragen zu seinen Vorhersagen zu stellen. Dies würde den Nutzern helfen, das Vorgehen der KI besser zu verstehen oder mithilfe ihres eigenen Urteilsvermögens zu überprüfen. Zudem könnte das Hinzufügen weiterer Erklärungsschritte dem System klarere Einblicke in die Entscheidungsfindung der KI geben.

Dieser Fortschritt stellt einen bedeutenden Schritt dar, um KI verständlicher für Menschen zu machen. Indem wir KI klarer und benutzerfreundlicher gestalten, können wir ihre Vorteile in vielen Bereichen nutzen, was Menschen in verschiedenen Branchen zu besseren Entscheidungen verhelfen wird.

Die Studie wird hier veröffentlicht:

http://dx.doi.org/10.48550/arXiv.2412.05145und seine offizielle Zitation - einschließlich Autoren und Zeitschrift - lautet

Alexandra Zytek, Sara Pido, Sarah Alnegheimish, Laure Berti-Equille, Kalyan Veeramachaneni. Explingo: Explaining AI Predictions using Large Language Models. Submitted to arXiv, 2024 DOI: 10.48550/arXiv.2412.05145Diesen Artikel teilen